近年来,人工智能(AI)的崛起引起了广泛的讨论和担忧,很多人担心AI会造成失业率飙升,而有些乐观的朋友则戏称“只要电费贵过馒头,AI就永远不能完全代替人”。

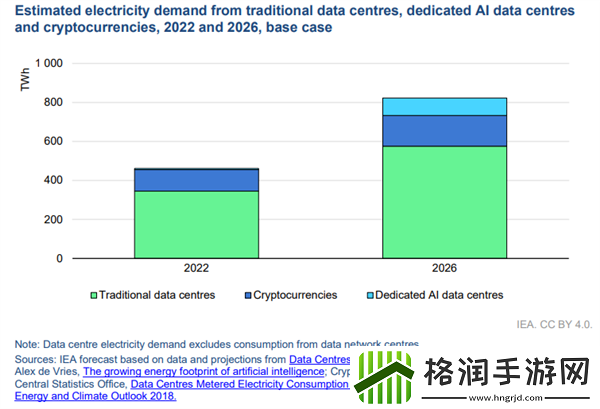

虽然这是句玩笑话,但背后则是实实在在的AI能耗问题,越来越多的人担忧高能耗将成为制约AI发展的瓶颈。

就在不久前,技术创业者、前谷歌工程师凯尔·科比特(Kyle Corbitt)在社交媒体X上表示,微软已经遇到了这方面的难题。

AI到底有多费电?

科比特称,训练GPT-6的微软工程师们正忙着搭建IB网络(InfiniBand),把分布在不同地区的GPU连接起来。这项工作很困难,但他们别无选择,因为如果把超过10万块H100芯片部署在同一个地区,电网就会崩溃。

来源:X@corbtt为什么这些芯片集中起来会导致电网崩溃的后果呢?让我们来简单算一笔账。

英伟达网站上公布的数据显示,每块H100芯片的峰值功率为700W,10万块H100峰值功耗最高可达7000万W。而X评论区有能源行业从业者指出,10万块芯片的总能耗将相当于一座小型太阳能或风能发电厂的全部输出。

除此之外,还要考虑这么多芯片的配套设施的能耗,包括服务器和冷却设备。这么多耗电设施,集中在一小片区域,给电网带来的压力可想而知。

AI耗电,冰山一角